两只羊驼掐头去尾拼一起,屠榜HuggingFace

HuggingFace开源大模型排行榜,又被屠榜了。

前排被清一色的SOLAR 10.7B微调版本占据,把几周之前的各种Mixtral 8x7B微调版本挤了下去。

SOLAR大模型什么来头?

相关论文刚刚上传到ArXiv,来自韩国公司Upstage AI,使用了新的大模型扩展方法depth up-scaling(DUS)。

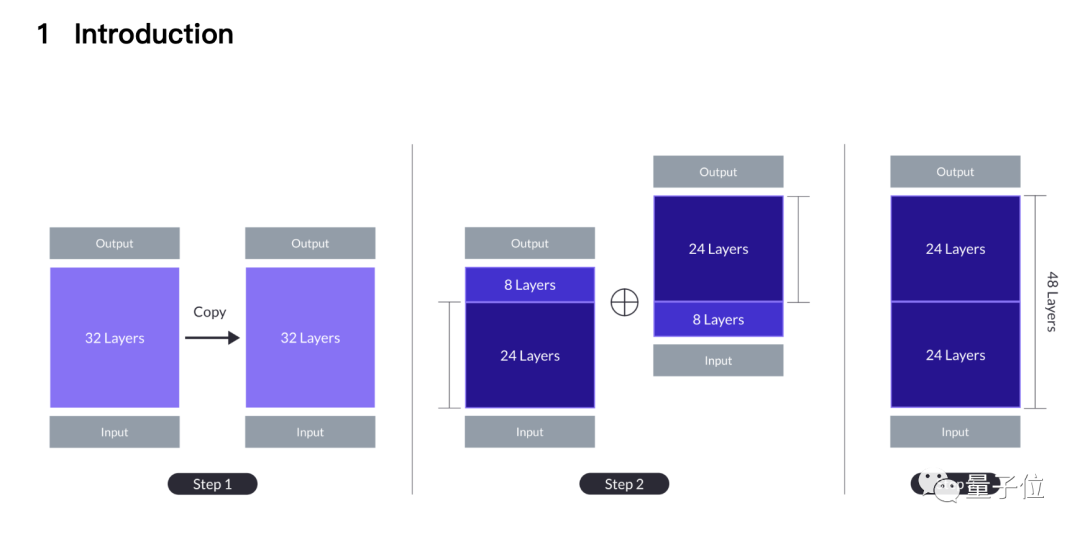

简单来说就是两只7B羊驼掐头去尾,一只砍掉前8层,一只砍掉后8层。

剩下两个24层缝合在一起,第一个模型的第24层与第二个模型的第9层拼接,最后变成新的48层10.7B大模型。

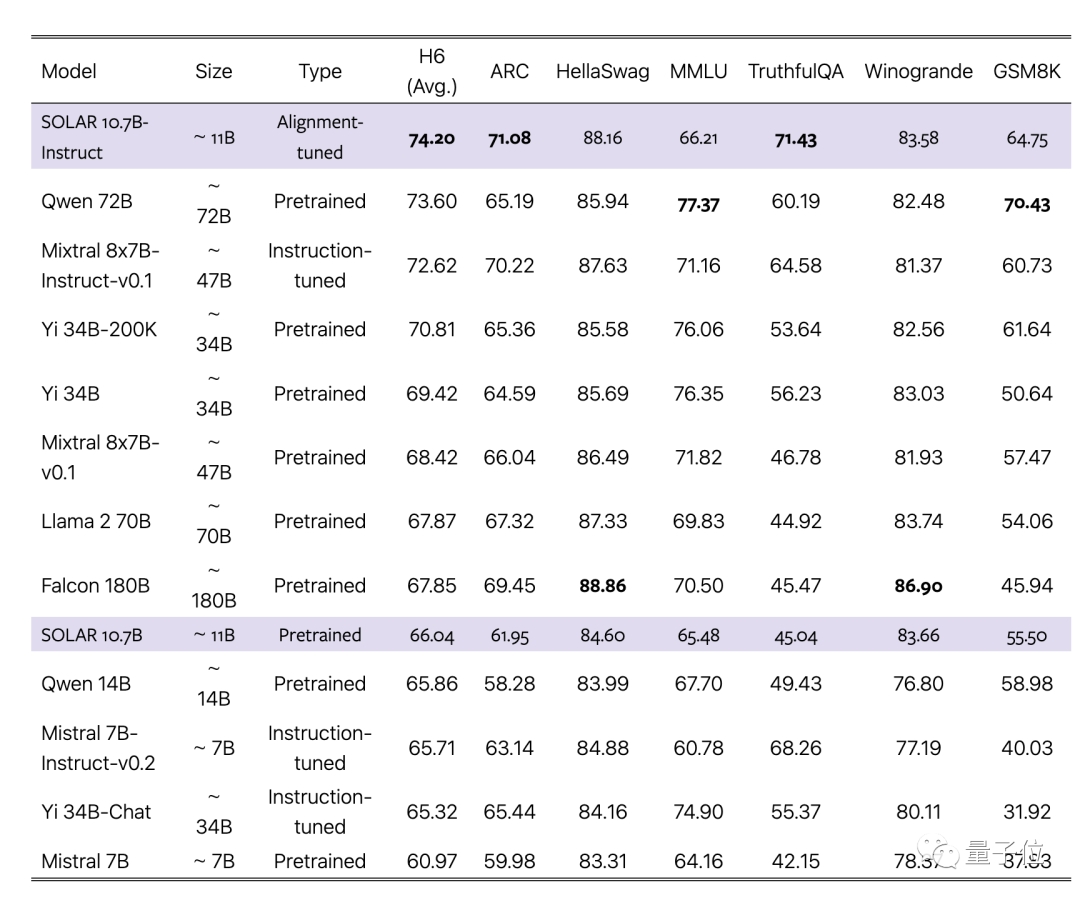

论文声称新方法超过传统扩展方法如MoE,而且可以与沿用基础大模型完全相同的基础设施。

不需要门控网络等附加模块,针对MoE优化训练框架了,也不需要自定义CUDA内核来快速推理,可以无缝集成到现有方法中,同时保持高效。

团队选择7B规模最强的单体大模型Mistral 7B作为底材,用新方法拼接起来,再超越原版以及MoE版。

同时,经过对齐的Instruct版本也超越对应的MoE Instruct版本。

将缝合进行到底

为什么是这种拼接方式,论文中介绍来自一种直觉。

从最简单的扩展方式开始,也就是把32层的基础大模型重复两次,变成64层。

这样做的好处是不存在异质性,所有层都来自基础大模型,但第32层和第33层(与第1层相同)的接缝处有较大的“层距离”(layer distance)。

之前有研究表明,Transformer不同层做不同的事,如越深的层擅长处理越抽象的概念。

团队认为层距离过大可能妨碍模型有效利用预训练权重的能力。

一个潜在的解决方案是牺牲中间层,从而减少接缝处的差异,DUS方法就从这里诞生。

根据性能与模型尺寸的权衡,团队选择从每个模型中删除8层,接缝处从32层连第1层,变成了24层连第9层。

简单拼接后的模型,性能一开始还是会低于原版基础模型,但经过继续预训练可以迅速恢复。

在指令微调阶段,除了使用开源数据集,还制作了数学强化数据集,对齐阶段使用DPO。

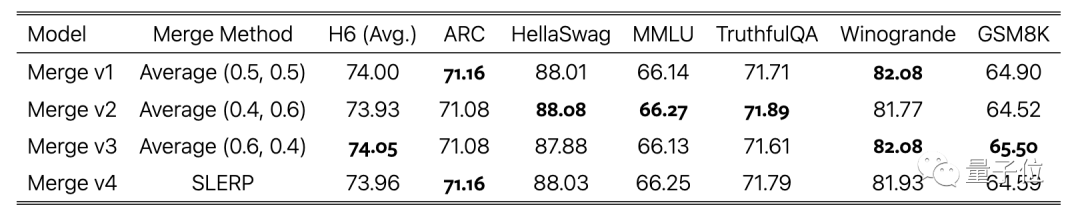

最后一步,把使用不同数据集训练的模型版本加权平均,也是把缝合进行到底了。

有网友质疑测试数据泄露的可能性。

团队也考虑到这一点,在论文附录中专门报告了数据污染测试结果,显示出低水平。

最后,SOLAR 10.7B基础模型和微调模型都以Apache 2.0协议开源。

试用过的网友反馈,从JSON格式数据中提取数据表现不错。

论文地址:https://arxiv.org/abs/2312.15166