用Python替代Adobe,零成本从PDF提取数据

创始人

2025-07-07 13:01:33

0次

一、简介

PDF文件是官方报告、发票和数据表的通用语言,然而从PDF文件中提取表格数据可能是一项挑战。尽管Adobe Acrobat等工具提供了解决方案,但它们并不总是易于获取或可自动化运行,而Python则是编程语言中的瑞士军刀。本文将探讨如何利用Python轻松实现PDF数据提取,而无需使用昂贵的软件。

二、了解挑战

PDF文件是为展示而设计的,而不是为提取数据。它们通常包含复杂的布局,在视觉上很吸引人,但在计算上却无法访问。因此,提取表格等结构化信息非常困难。

三、使用PyMuPDF提取文本

PyMuPDF是一款轻量级的库,擅长读取PDF文件并提取文本。只需几行代码,就可以读取PDF并从任意页面提取文本。本文从奔驰集团2022年第四季度年度报告中提取“股东权益变动综合报表(Consolidated Statement of Changes in Equity)”,代码如下。

import fitz

import pandas as pd

import re

# --- PDF处理 ---

# 定义PDF文件的路径并打开文档

pdf_path = '..../Merc 2022Q4 Rep.pdf'

pdf_document = fitz.open(pdf_path)

# 选择要阅读的特定页面

page = pdf_document[200]

# 获取页面的尺寸

page_rect = page.rect

page_width, page_height = page_rect.width, page_rect.height

# 定义感兴趣区域的矩形(不包括脚注)

non_footnote_area_height = page_height * 0.90

clip_rect = fitz.Rect(0, 0, page_width, non_footnote_area_height)

# 从定义的区域提取文本

page_text = page.get_text("text", clip=clip_rect)

lines_page = page_text.strip().split('\n')四、规整数据

提取的文本通常带有不需要的字符或格式。这就是预处理发挥作用的地方。Python的字符串处理功能使用户能够清洗和准备数据以转换为表格格式。

# --- 数据清洗 ---

# 定义要搜索的字符串并查找其索引

search_string = 'Balance at 1 January 2021 (restated) '

try:

index = lines_page.index(search_string)

data_lines = lines_page[index:]

except ValueError:

print(f"The string '{search_string}' is not in the list.")

data_lines = []

# 如果不是数字或连字符,则合并连续字符串条目

def combine_consecutive_strings(lines):

combined = []

buffer = ''

for line in lines:

if isinstance(line, str) and not re.match(r'^[-\d,.]+$', line.strip()):

buffer += ' ' + line if buffer else line

else:

if buffer:

combined.append(buffer)

buffer = ''

combined.append(line.strip())

if buffer:

combined.append(buffer)

return combined

cleaned_data = combine_consecutive_strings(data_lines)五、使用Pandas创建表格

一旦数据清洗完成,就可以使用pandas了。这个功能强大的数据分析库可以将一系列数据点转换为DataFrame,即一个二维的、大小可变的、可能是异构的带有标记轴的表格数据结构。

# --- 创建DataFrame ---

# 根据列数将清洗后的数据分割成块

num_columns = 6

data_chunks = [cleaned_data[i:i + num_columns] for i in range(0, len(cleaned_data), num_columns)]

# 定义DataFrame的表头

headers = [

'Description',

'Share capital',

'Capital reserves',

'Retained earnings (restated)',

'Currency translation (restated)',

'Equity instruments / Debt instruments'

]

# 使用数据块和表头创建DataFrame

financial_df = pd.DataFrame(data_chunks, columns=headers)

# Display the head of the DataFrame to verify its structure

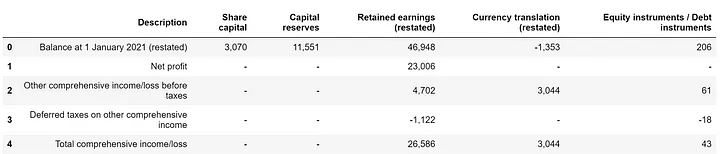

financial_df.head()如下所示是从PDF文件中提取的表格结果。

图片

图片

六、结语

通过利用Python强大的库,可以自动化繁琐的PDF数据提取任务。这种方法不仅成本低,而且提供了Python开发者所喜爱的灵活性和强大功能。

相关内容

热门资讯

PHP新手之PHP入门

PHP是一种易于学习和使用的服务器端脚本语言。只需要很少的编程知识你就能使用PHP建立一个真正交互的...

网络中立的未来 网络中立性是什...

《牛津词典》中对“网络中立”的解释是“电信运营商应秉持的一种原则,即不考虑来源地提供所有内容和应用的...

各种千兆交换机的数据接口类型详...

千兆交换机有很多值得学习的地方,这里我们主要介绍各种千兆交换机的数据接口类型,作为局域网的主要连接设...

全面诠释网络负载均衡

负载均衡的出现大大缓解了服务器的压力,更是有效的利用了资源,提高了效率。那么我们现在来说一下网络负载...

什么是大数据安全 什么是大数据...

在《为什么需要大数据安全分析》一文中,我们已经阐述了一个重要观点,即:安全要素信息呈现出大数据的特征...

如何允许远程连接到MySQL数...

[[277004]]【51CTO.com快译】默认情况下,MySQL服务器仅侦听来自localhos...

如何利用交换机和端口设置来管理...

在网络管理中,总是有些人让管理员头疼。下面我们就将介绍一下一个网管员利用交换机以及端口设置等来进行D...

P2P的自白|我不生产内容,我...

现在一提起P2P,人们就会联想到正在被有关部门“围剿”的互联网理财服务。×租宝事件使得劳...

Intel将Moblin社区控...

本周二,非营利机构Linux基金会宣布,他们将担负起Moblin社区的管理工作,而这之前,Mobli...

施耐德电气数据中心整体解决方案...

近日,全球能效管理专家施耐德电气正式启动大型体验活动“能效中国行——2012卡车巡展”,作为该活动的...