AI「领悟」有理论解释了!谷歌:两种脑回路内部竞争,训练久了突然不再死记硬背

谷歌PAIR团队不久前撰文介绍了AI的“领悟” (Grokking)现象——

训练久了突然不再死记硬背,而是学会举一反三,有了泛化能力。

不出一个月,另一只团队(主要成员来自DeepMind)表示,已经给出一个通用理论解释——

领悟又称延迟泛化,与AI内部两种“脑回路”的竞争有关。

对此,有学者评价“我们需要更多这种对深度学习物理规律的研究,而不是去优化炼金术。”

AI的两种脑回路

在先前的研究中,发现在“领悟”现象的作用下,就算只有5-24个神经元的模型也能拥有泛化能力。

新研究沿用了这种构建最小示例,以及大量做可视化的方法。

基于OpenAI在2020年一项对神经网络内部机制之间相互作用的研究,团队假设并验证了模型内部有两种算法回路(Circuits)。

- 记忆回路Cmem,训练时表现很好,但测试时表现不佳。

- 泛化回路Cgen,训练和测试阶段表现都好。

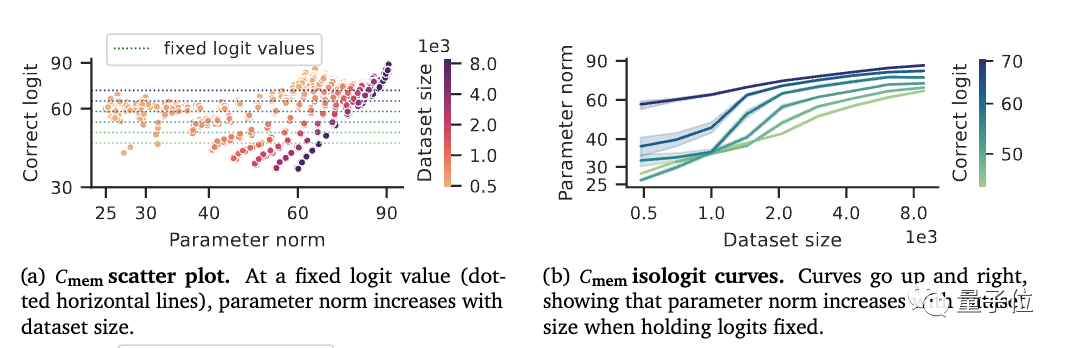

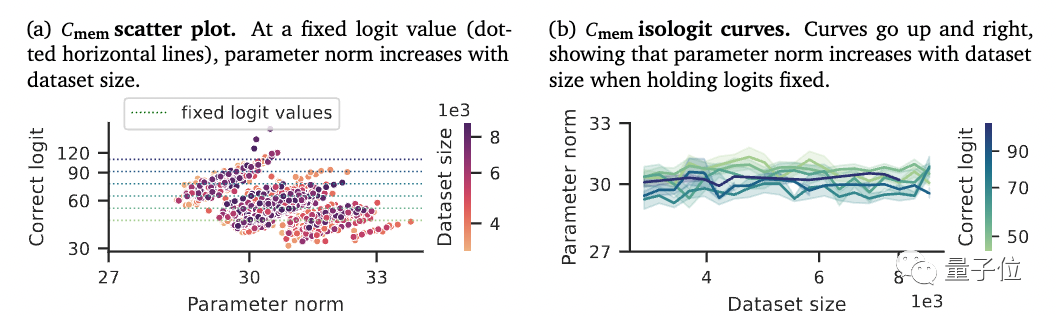

通过改变数据集的大小和权重衰减的强度做实验来观察。

当训练数据集增大时,Cmem回路的参数范数也更大,也就是在靠记忆的方式去存储训练集需要的信息量。

但Cgen的参数范数不随训练集大小变化,也就是获得了类似“举一反三”的泛化能力

那么,在什么条件下模型会发生整体的“领悟”现象呢?

来自两种回路的之间竞争。

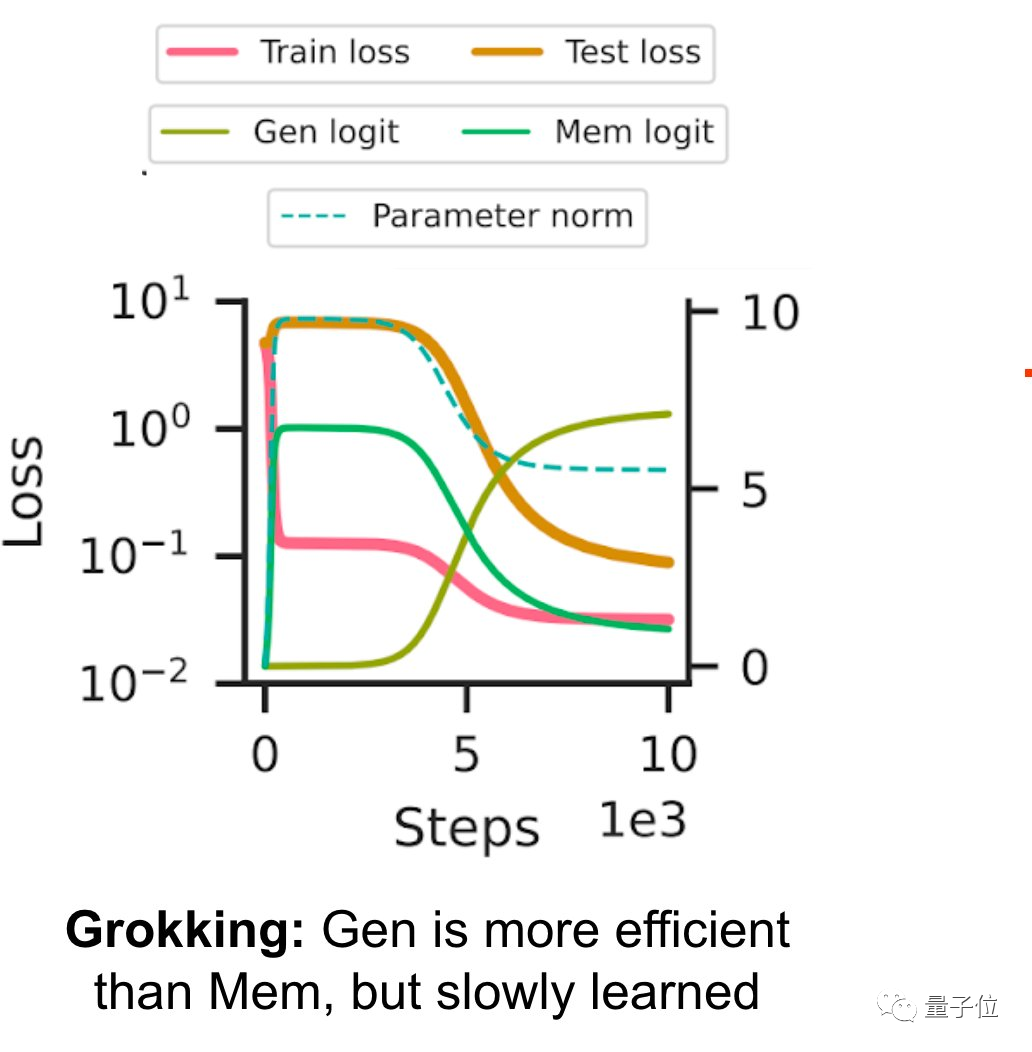

在训练初期,直接死记硬背的速度更快,Cmem占据上风。

但随着数据的增加,在梯度下降的作用下效率更高的Cgen会被加强。

也就是说,存在两种不同的回路、他们之间有效率差和学习速度差是导致领悟发生的三大要素。

重新思考泛化

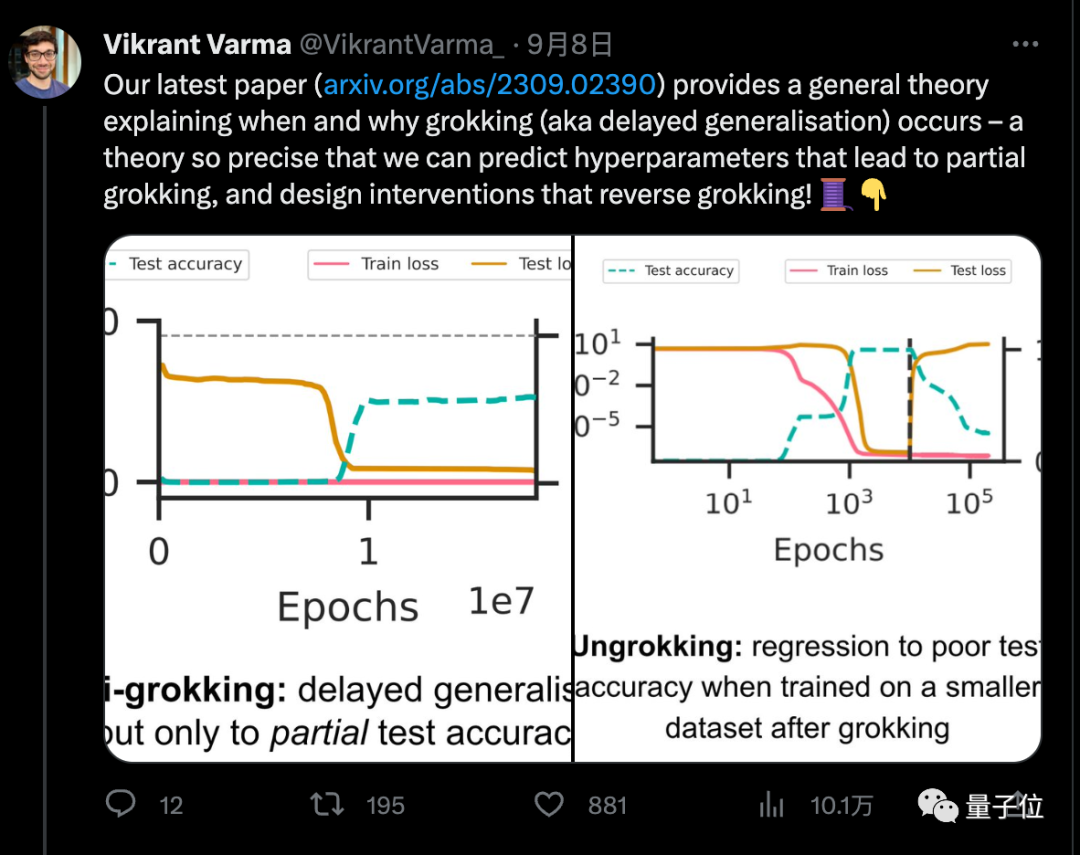

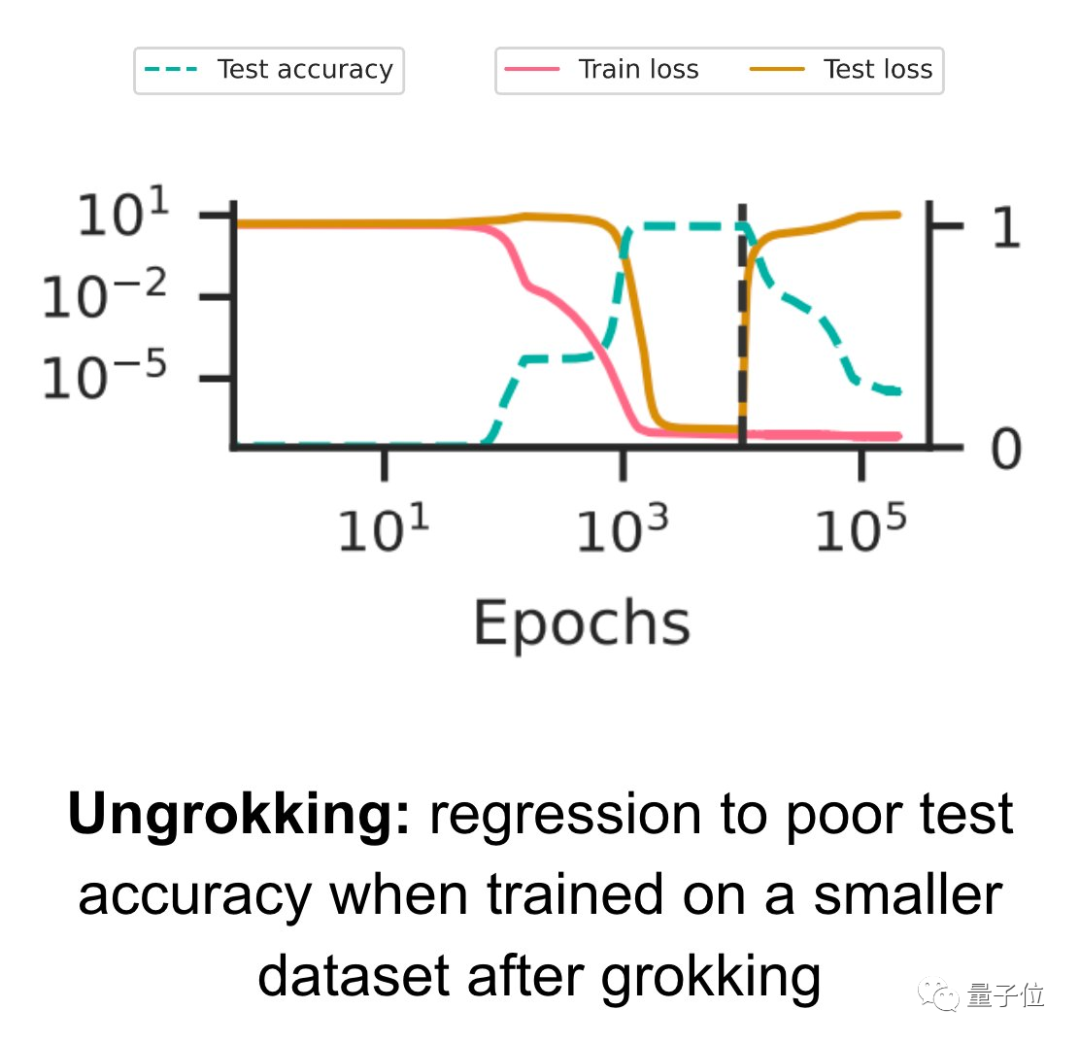

在更进一步的实验中,团队还根据这个理论成功演示了在一定条件下,已经“领悟”的模型也可以退化,出现“逆领悟”。

在新的小数据集上继续训练已领悟的模型时,测试精度突然变差,也就是在泛化之后的过拟合。

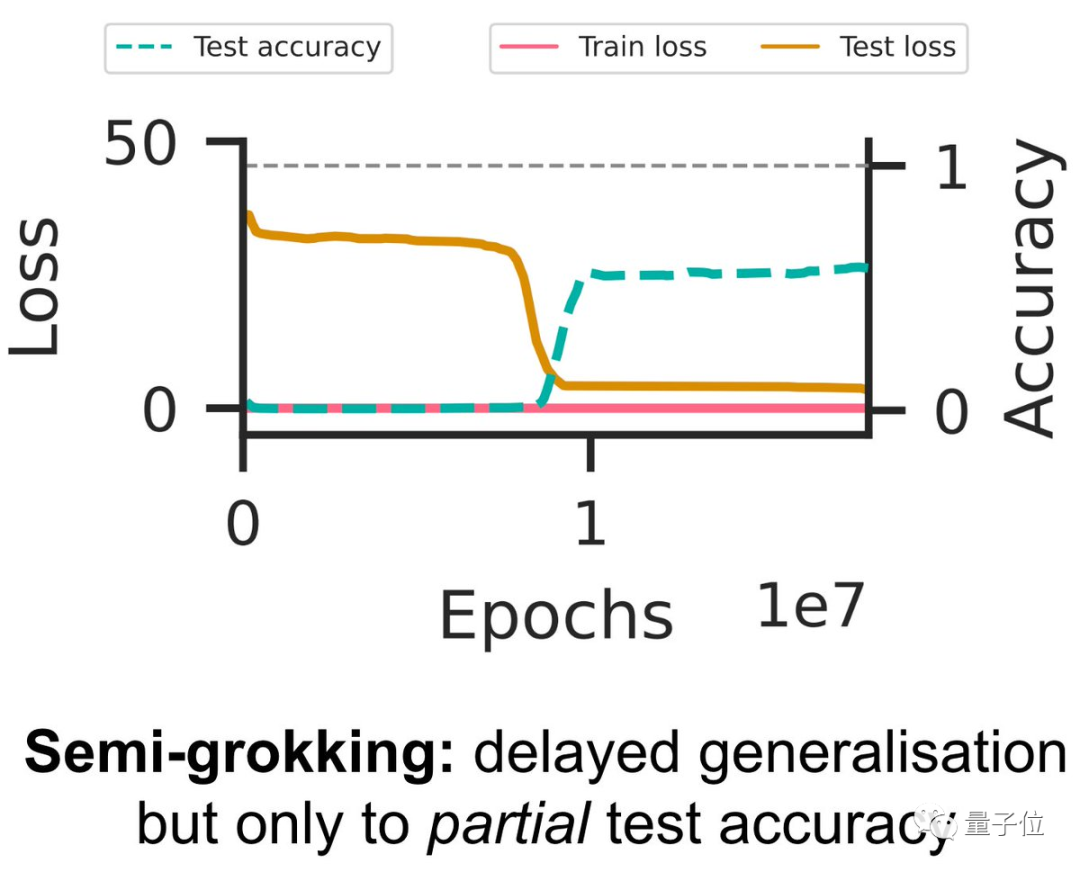

也可以精心调整出一个“半领悟”状态。

当数据集的大小刚好在一个临界值,让Cmem和Cgen的效率相当,只对部分测试精度出现延迟泛化。

团队认为,这种基于回路效率的分析为理解神经网络的泛化提供了一种新的视角。

同时也提出了一些后续研究方向。

如为什么领悟所需的时间随数据集大小的减小呈超指数级增长?为什么Cgen回路的学习速度慢?为什么在没有权重衰减的情况下也会发生grokking?为什么在典型的机器学习训练中没有领悟现象?……

评论区有学者认为,研究这些基础问题并不需要成千上万块H100。

GPU贫民也有机会为整个领域做出贡献。

论文地址:https://arxiv.org/abs/2309.02390

参考链接:

[1]https://x.com/VikrantVarma_/status/1699823229307699305

[2]https://pair.withgoogle.com/explorables/grokking/